Humanos sintéticos - Los modelos e influencers de IA en poder del Cibercrimen

Estamos entrando en un período en el que comenzamos a observar el auge de influencers creados mediante inteligencia artificial, capaces de generarse completamente desde cero, imitar movimientos, gestos o bailes, promocionar productos e incluso realizar canjes con empresas, del mismo modo que lo haría una persona real.

Ahora nos olvidamos que la inteligencia artificial no solo facilita y acrecienta este tipo de situaciones sino que también acelera el uso en ciberdelitos y en este articulo queremos contarles un poco los alcances que pueden haber, además de los tipos de técnicas que se podrían utilizar, ya que cada vez resulta más complejo para los usuarios distinguir entre perfiles genuinamente humanos y aquellos generados o asistidos por IA en redes sociales.

Este post es de alguna manera una continuación del primero publicado aquí en la ciberteca (https://www.laciberteca.blog/la-importancia-del-analisis-identificando-cuentas-falsas-que-hacen-uso-de-ia-y-posibles-estafas/) aunque con un enfoque más orientado a mostrar la sencillez con la que actores criminales pueden aprovechar estas tecnologías para cometer fraudes contra la comunidad, así como los riesgos que se proyectan a futuro.

Del marketing a la facilitación del fraude

Hoy alcanza con encontrarse con un solo video en Instagram o TikTok que muestre cómo crear este tipo de influencers. La mayoría viene acompañado de promesas de empezar a generar dinero, muy similares a las que podría hacer una persona real, pero con la idea de que requieren menos tiempo y dedicación. A partir de ahí, el algoritmo hace el resto y empieza a mostrar decenas de reels con aplicaciones y herramientas para generarlos casi de forma automática.

El problema aparece cuando en toda esa difusión se deja de lado el contexto. Se habla mucho de creatividad, automatización y productividad, pero muy poco de los riesgos. Las mismas tecnologías que permiten generar imágenes realistas, clonar voces o simular identidades digitales también pueden ser utilizadas para engañar, suplantar personas y cometer fraudes.

Desde la mirada del cibercrimen, este escenario es ideal. Hoy no hace falta tener grandes conocimientos técnicos para montar una estafa, muchas veces alcanza con usar herramientas promocionadas públicamente, seguir tutoriales que circulan en redes y copiar esquemas que otros ya probaron. El problema no está en la inteligencia artificial en sí, sino en cómo se la normaliza sin explicar sus implicancias, ya que al mostrar solo los beneficios se termina ampliando un ecosistema que el cibercrimen sabe aprovechar muy bien.

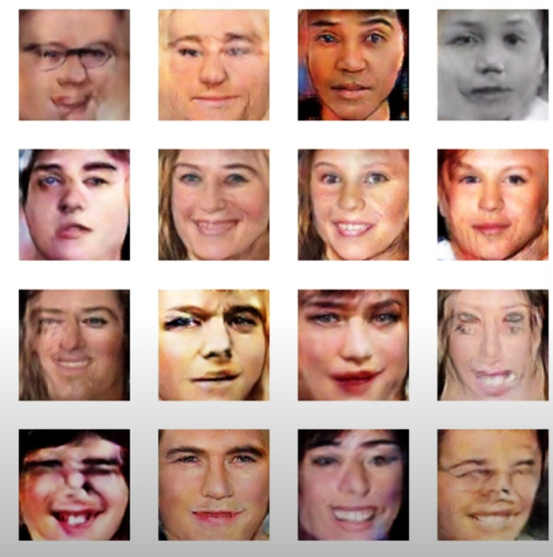

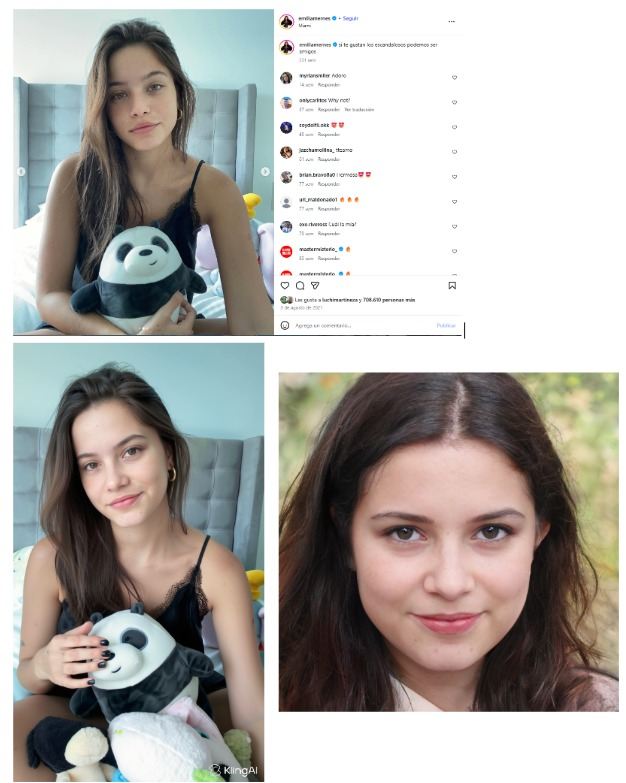

Ejemplo de lo que podemos encontrar en reels de Instagram

La utilización de los modelos de inteligencia artificial generativa, en combinación con los efectos, filtros o extensiones que proporcionan las redes sociales y/o herramientas digitales, están permitiendo obtener resultados casi realistas de imágenes o videos de “humanos sintéticos”, muchas veces utilizados para manipular y engañar al ojo humano.

Este desarrollo presenta una gran dificultad para distinguir lo real de lo falso que podemos observar en nuestras pantallas, comprometiendo la autenticidad y la ética del contenido.

Plataformas utilizadas por la comunidad están permitiendo dar el poder al usuario, para modificar sus aspectos en tiempo real y engañar cada vez más a el receptor de esa imagen. Esto provoca en muchos casos, que estas herramientas puedan ser utilizadas para actividades ilícitas, donde se intenta engañar y manipular a las personas (tanto mayores cómo menores).

Fuente: DEUTSCHE TELEKOM

Redes generativas adversarias (GANs):

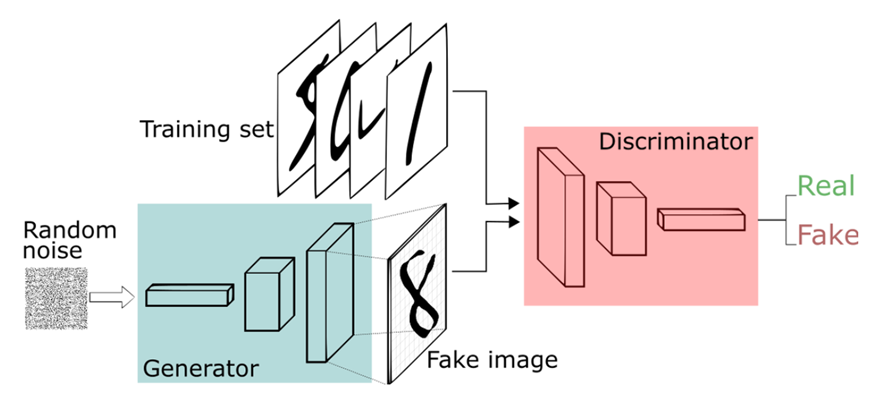

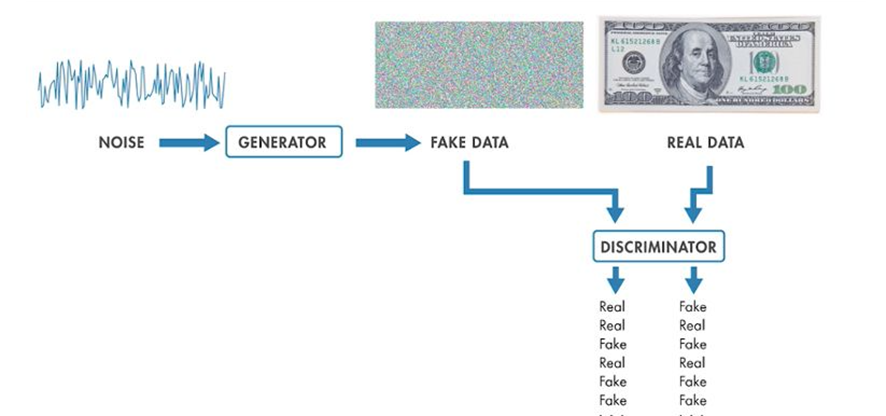

Para entender más sobré este método de engaño, tenemos que comprender el funcionamiento de las GANs o redes generativas adversarias. (Modelo de inteligencia que contiene dos redes que interactúan entre sí, para generar algo completamente nuevo).

Principalmente tenemos que saber que existen dos modelos diferentes, uno de ellos denominado discriminativo y otro generativo.

Modelo Discriminativo vs Generativo:

-Modelos discriminativos: Modelos de inteligencia artificial que sirven para generar predicciones acerca de datos futuros adquiriendo cómo base datos actuales, con los cuales previamente se ha entrenado al modelo.

-Modelos generativos: Modelos de inteligencia artificial que son entrenados, utilizando datos para que aprendan la distribución subyacente de los datos. Una vez que esa distribución haya sido aprendida por la inteligencia, podemos usarla para generar datos nuevos (que no existen en la realidad) pero que pertenece a esa distribución ya aprendida por el modelo. A estos nuevos datos se le asignará el nombre cómo datos sintéticos, ya que son desarrollados por la IA, para que los mismos sean indistinguibles.

Además, las redes generativas se dividen en dos grandes grupos, uno de ellos denominado redes generativa adversarias (GANs) y los Variational autoencoder (VAE).

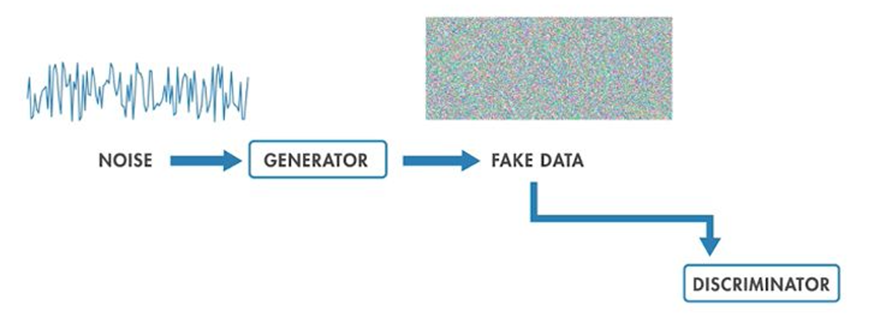

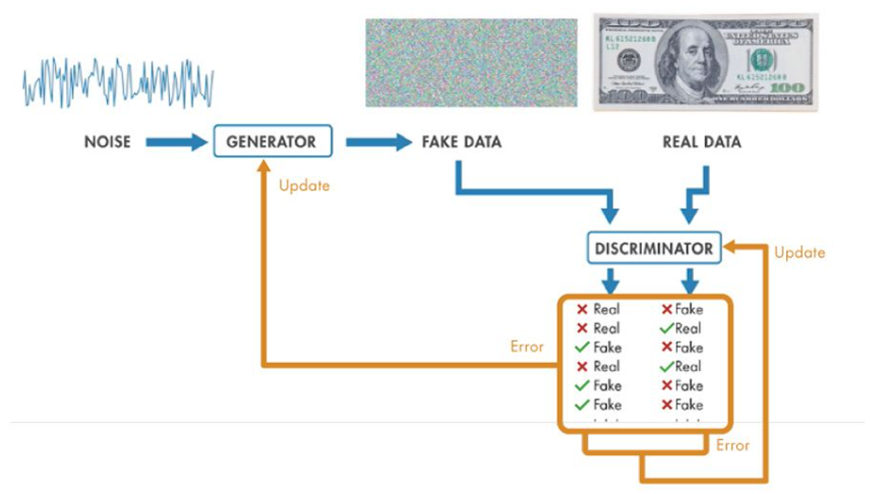

En este caso nos centraremos en el funcionamiento de las GANs, ya que es el modelo utilizado para generar imágenes nuevas de “la nada”, a raíz de que se entrena una red encargada (Discriminador) de determinar si dos conjuntos de datos fueron extraídos de la misma fuente o distribución.

Funcionamiento de las GANs:

Al “Discriminador” se le entregará imágenes reales e imágenes falsas que provienen de los siguientes sectores:

▪ Sector 1: |Training yet| Una fase de entrenamiento, en la cual se aloja una base de imágenes reales ya incorporadas previamente, para que el modelo empiece a entrenar.

▪ Sector 2: |Generador| Una red entrenada para confundir al Discriminador, encargada de adquirir “ruido” (datos aleatorios) con la finalidad de generar imágenes falsas que luego se les entregará al Discriminador.

Al obtener estos dos datos del Sector 1 y Sector 2, la red "Discriminadora" tratará de predecir si la imagen es real o falsa.

¿Por qué se llaman adversarias? 😇vs😈

En resumen, este modelo se denomina adversario ya que nos está mostrando dos bandos, el bueno y el malo.

El malo sería el "Generador" qué intentará a toda costa generar imágenes falsas para confundir al "Discriminador".

Y el bueno, en este caso el "Discriminador", que intentará a toda costa, descifrar cual es la imagen real de la falsa.

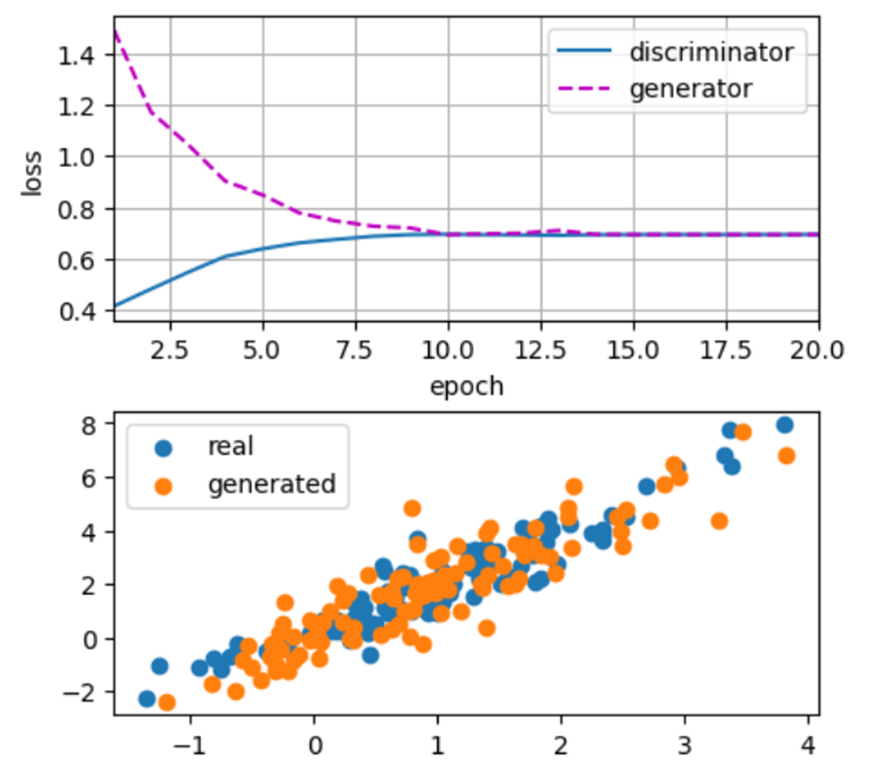

Está pelea constante hace que las dos redes se entrenen constantemente y que el “Generador” cada vez realicé imágenes falsas más reales y que el “Discriminador” generé técnicas diferentes y mejores para descifrar que imágenes son falsas.

Todo esto se encuentra acompañado de un proceso matemático y variables desarrolladas para el correcto funcionamiento de este modelo. Aunque, lo más relevante y que nos va a interesar a nosotros, es el resultado que nos entregará el "Generador", que fue incentivado por el "Discriminador" para hacerse cada vez mejor en su propósito, el proporcionar imágenes detalladas y casi realistas, pero inexistentes.

Este Discriminador se terminará convirtiendo en lo que conocemos cómo Modelos generativos potentes.

Para esto se utilizará lo que se conoce cómo Redes Generativas Adversarias Convulsiónales Profundas (DCGAN), similar a las GANs, pero que generan imágenes a través de redes convulsiónales profundas.

Esto da como resultado imágenes creadas de las nada, que nos permitirá posteriormente utilizarlas cómo -quisiésemos.

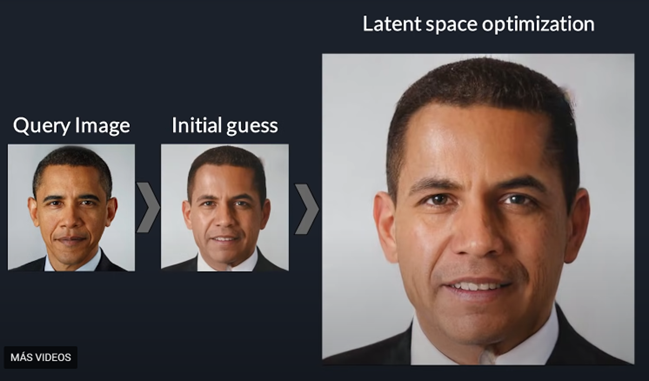

A esto se le suma nuevas tecnologías que no solo están permitiendo entregar imágenes falsas, si no que también se está permitiendo la creación de rostros sintéticos superpuestos en personas reales (Face Swapping) en tiempo real, logrando convencer a los receptores de ese contenido, qué lo que están viendo realmente existe.

Técnicas usadas por el cibercrimen con IA

Ya conociendo conceptos base para el entendimiento académico detrás, hablamos que el uso de IA por parte del cibercrimen no responde a un escenario futurista sino a una adopción pragmática de herramientas ya disponibles en el mercado que reducen barreras, escalan operaciones y mejoran la capacidad de engaño. A continuación, describimos algunas de las técnicas más relevantes observadas en la actualidad.

Manipulación audiovisual sintética

La manipulación audiovisual sintética ha adquirido un rol relevante dentro del ecosistema del cibercrimen. En sus primeras etapas, este tipo de técnicas se limitaba principalmente a casos aislados de suplantación de identidad mediante imágenes estáticas o al uso de herramientas capaces de sustituir rostros en videos y transmisiones en vivo a través de cámaras web.

En aquel momento, los principales factores restrictivos para quienes querían utilizar estas herramientas de manera ilícita, eran los recursos disponibles que tenían en su poder. Por un lado, la falta de tecnología adecuada, especialmente a nivel de hardware y por otro, los elevados costos de muchas de las herramientas existentes, que hacían no rentables para el uso del cibercrimen.

Asimismo, la calidad de los resultados representaba un obstáculo significativo. Las limitaciones técnicas de estas herramientas generaban fallas evidentes en las imágenes y videos producidos, impidiendo alcanzar un nivel de realismo audiovisual suficiente como para resultar creíble o eficaz en escenarios de suplantación.

En un período de tiempo relativamente corto, y gracias a una acelerada retroalimentación de conocimiento por parte de los modelos de IA generativa (GenAI), se alcanzó un punto en el que la percepción de lo que es real y lo que no, ha sufrido una transformación drástica, representando un riesgo creciente desde la perspectiva de la ciberseguridad.

Las mejoras introducidas no se limitan únicamente a la generación de imágenes o audios con mayor nivel de realismo, sino que ha realizado un salto cualitativo en la creación y manipulación de contenido en video. Mientras que, hasta hace poco, este tipo de material solo podía producirse a partir de descripciones textuales (prompts), en la actualidad es posible utilizar imágenes reales o sintéticas como base, dotarlas de movimiento y coherencia, o incluso sustituir objetos, rostros o elementos completos dentro de un video real por otros generados artificialmente.

Este avance redefine las reglas del juego, ya que estas capacidades no solo se emplean con fines legítimos de creación de contenido, sino que también ha abierto una superficie de ataque relevante para actividades delictivas en los entornos digitales.

Herramientas para la manipulación audiovisual sintética

En este punto refrescaremos los principales herramientas de GenAI y la funcionalidad que cumple cada uno de ellos, e incluiremos aquellos desarrollos más recientes que han demostrado ser de especial utilidad en escenarios de fraude y otras actividades delictivas digitales.

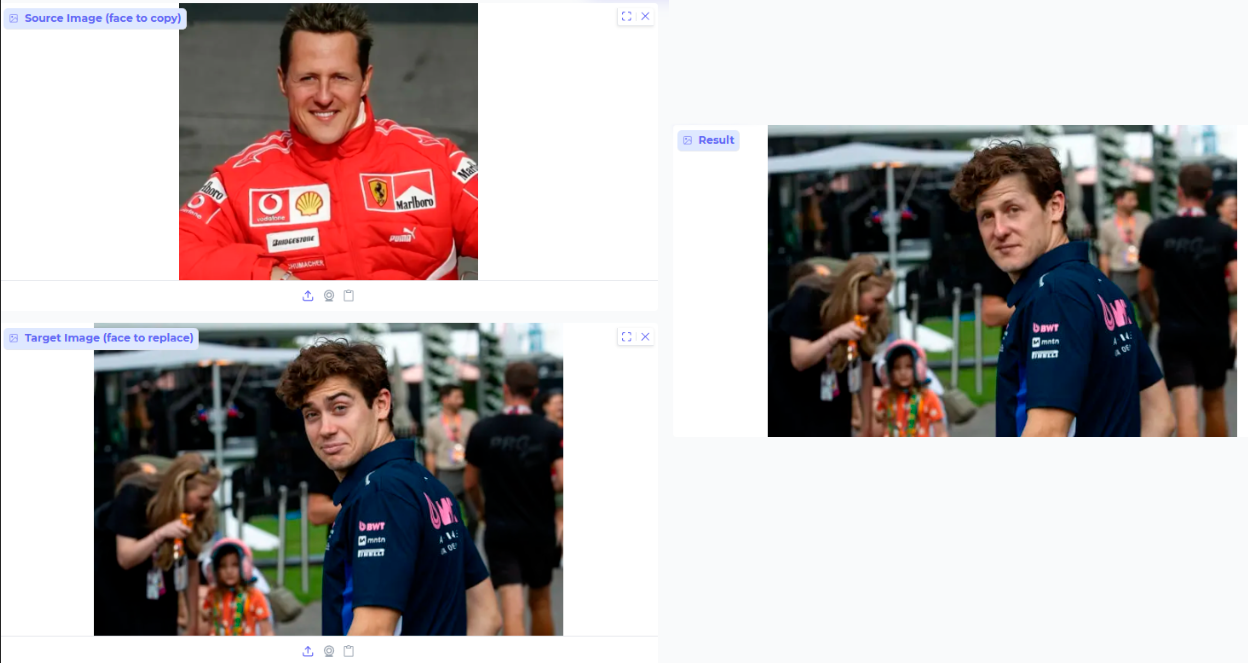

Face Swap

Es un proceso de GenAI que permite intercambiar la identidad facial de una persona por la de otra en imágenes o videos, manteniendo la postura, la iluminación y el contexto de la escena original.

La limitación principal de esta herramienta radica en que la GenAI utilizada está diseñada únicamente para reemplazar el rostro, sin poder alterar otras características de la imagen o el video, como el cuerpo, el fondo o los objetos presentes en la escena.

Este es uno de los primeros métodos utilizados para la suplantación de identidad, tanto en el ámbito de la seguridad biométrica como en los intentos de los actores de amenaza por evadir procesos de seguridad y controles biométricos.

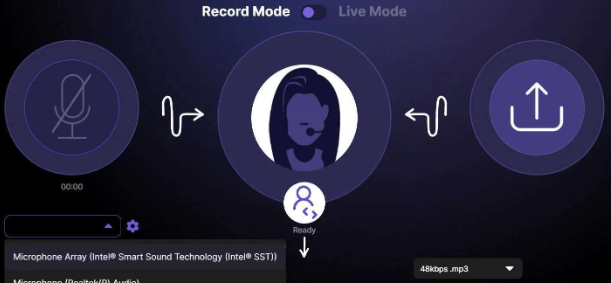

Deep Voice

Es un proceso que se centra en la síntesis y clonación de voz, y permite crear audios muy realistas imitando la voz de una persona, incluso si nunca ha pronunciado el contenido generado.

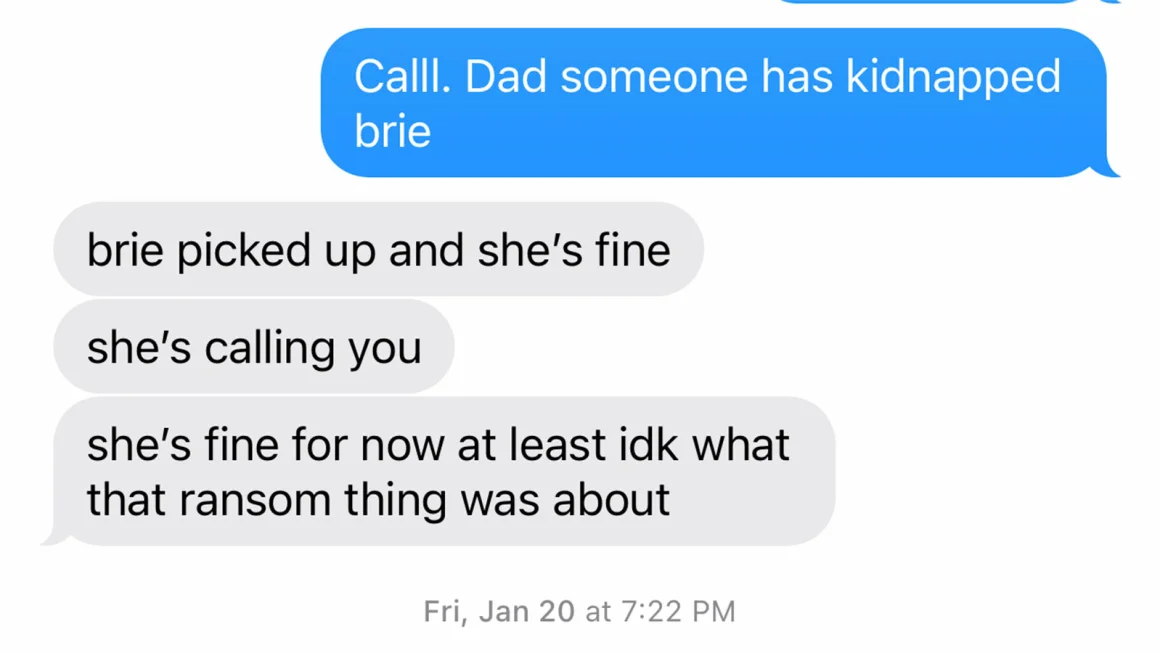

Este método experimentó un crecimiento significativo en su uso dentro de esquemas de secuestro virtual, donde fue empleado para engañar a familiares mediante la simulación del secuestro de menores de edad en distintos puntos del mundo. En estos casos, los atacantes utilizan audios generados mediante técnicas de d, apoyándose en la obtención previa de grabaciones reales de la supuesta víctima, lo que les permite crear clonaciones de voz altamente realistas y convincentes.

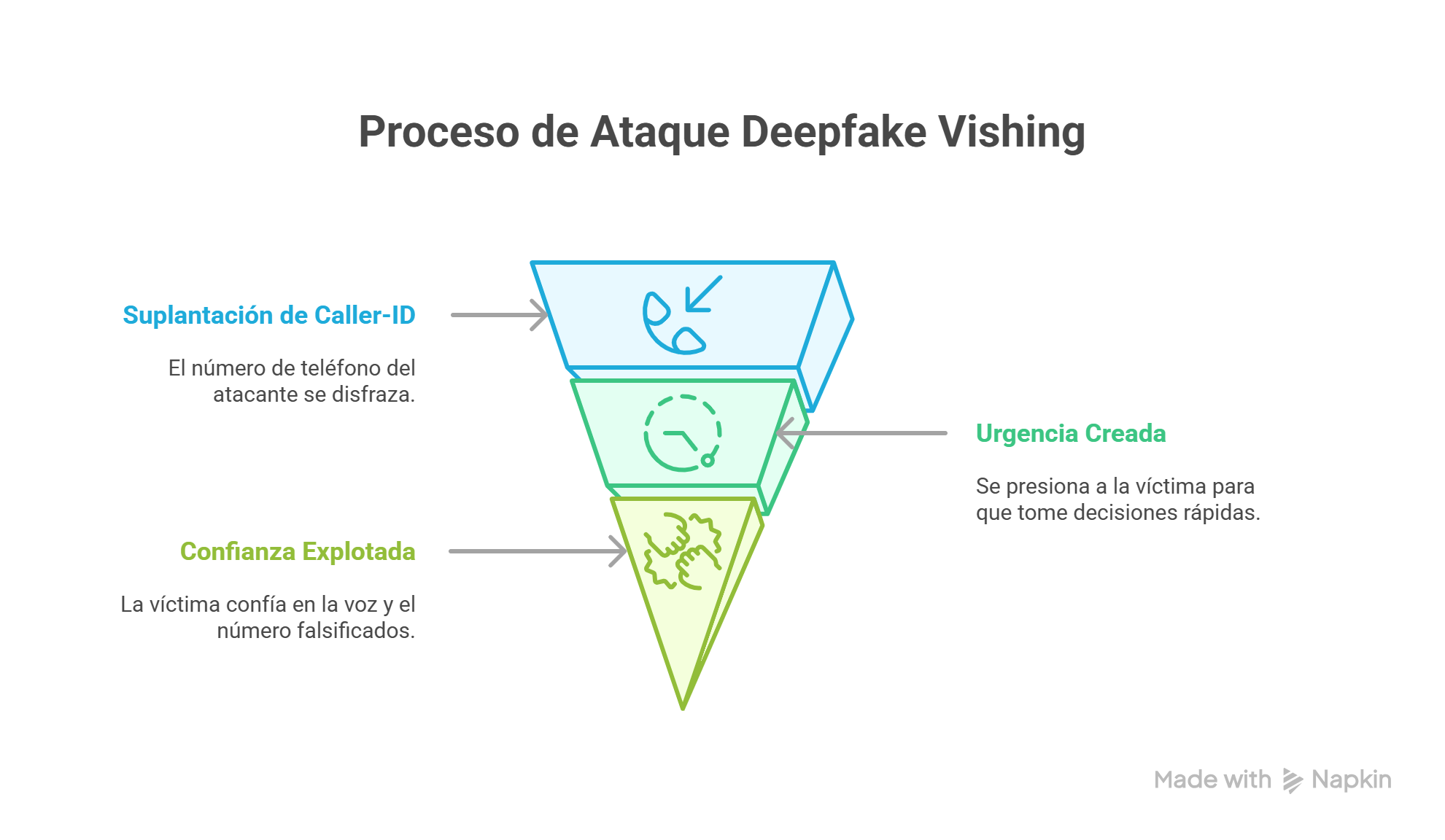

Deepfake vishing + caller ID spoofing (vishing “con identidad prestada”)

En este escenario se combinan dos técnicas que, juntas, potencian significativamente el fraude. El deepfake vishing se basa en la clonación de voz mediante inteligencia artificial para simular la identidad de una persona real durante una llamada telefónica. A esto se suma el caller ID spoofing, una técnica que permite falsificar el número desde el cual se origina la llamada, haciendo que en la pantalla del receptor aparezca un contacto legítimo, como un familiar, un proveedor o un número corporativo conocido.

La efectividad de esta combinación radica en que se apoyan en dos señales de confianza muy comunes. Por un lado, el reconocimiento de una voz familiar y, por otro, la validación visual del número entrante. Cuando ambas coinciden, la capacidad de cuestionar la autenticidad de la comunicación se reduce notablemente, sobre todo en situaciones de urgencia o presión.

Este tipo de ataques no apunta a vulnerar sistemas complejos, sino a explotar hábitos cotidianos. La confianza en lo que vemos y escuchamos sigue siendo un factor central, y la inteligencia artificial permite que esa confianza sea manipulada con una precisión cada vez mayor.

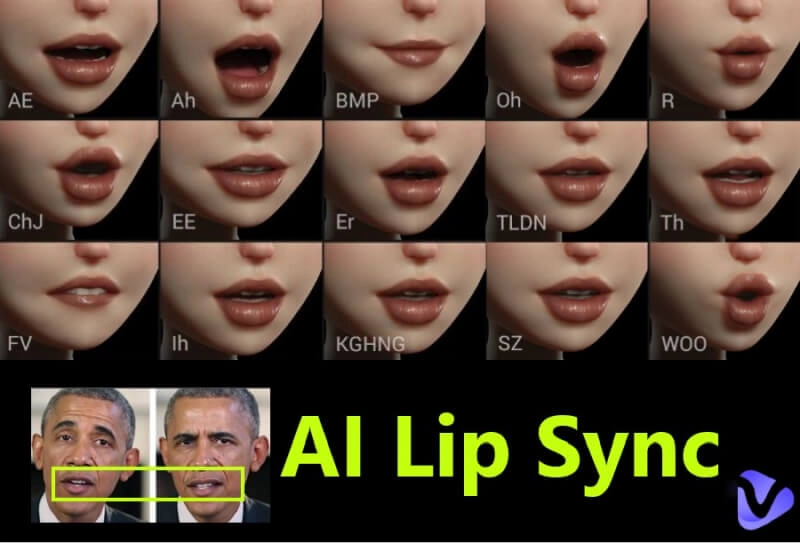

Lip Sync

Es un proceso mediante el cual se sincronizan los movimientos de los labios y expresiones faciales de una persona en un video con un audio específico, ya sea real o sintético.

El uso de Lip Sync ha cobrado relevancia principalmente en actividades de desinformación. Esta técnica permite sincronizar los movimientos de los labios y expresiones faciales de una persona con audios generados o manipulados, creando la ilusión de que el sujeto pronuncia palabras o mensajes que en realidad nunca dijo. Su capacidad para producir videos convincentes lo convierte en una herramienta potente para difundir información falsa, manipular narrativas públicas y afectar la percepción de la audiencia que son muchas veces emitida por redes sociales como Instagram o TikTok.

Fuente: Washington Post

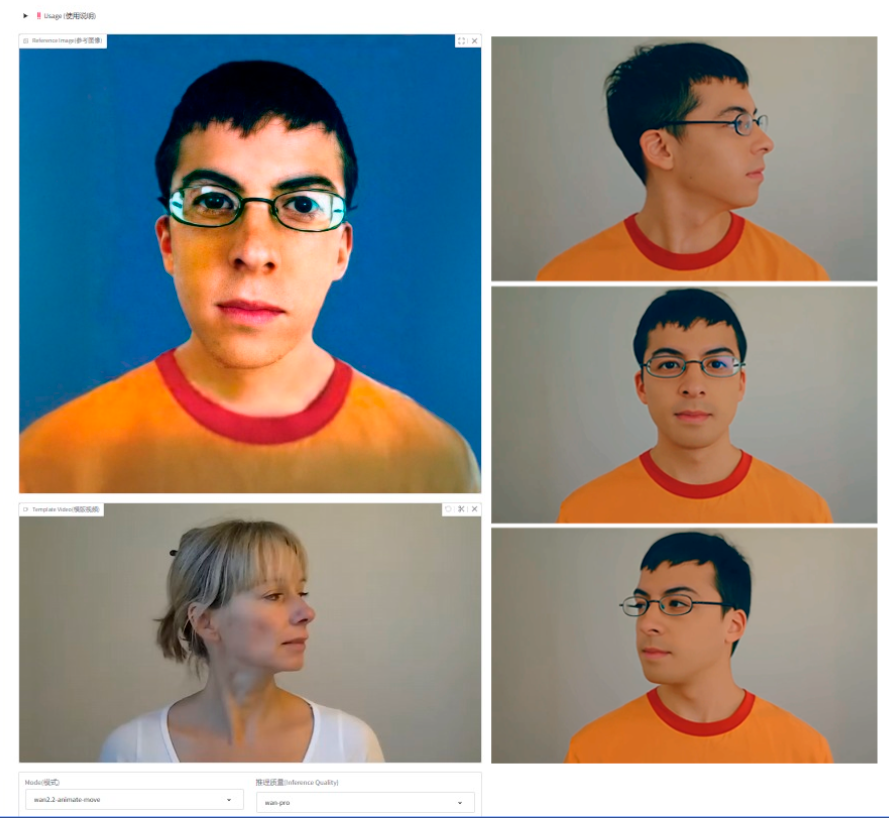

Swap All Character AI - Mimic AI

En este punto surge un nuevo proceso de GenAI, accesible para cualquier usuario, que permite reemplazar por completo a un personaje en una imagen o video, así como replicar sus movimientos de manera precisa. Para facilitar su comprensión y análisis, podemos dividir este proceso en dos categorías, Swap All Character AI y Mimic AI.

Swap All Character es un proceso de GenAI que permite sustituir completamente uno o varios personajes en una imagen o video por otros, preservando la coherencia de la escena, la iluminación y la interacción con el entorno.

Simulación Swap All Character con Vladimir Putin

Para que este proceso funcione adecuadamente es necesario tener una imagen objetivo de cuerpo completo de el personaje a utilizar en un video original. Esto permite tener mayor efectividad ante los distintos movimientos y planos de la grabación.

Mimic AI es un término general que se usa para describir tecnologías de IA generativa diseñadas para imitar o replicar comportamientos o expresiones humanas. Dependiendo del contexto, puede abarcar desde clonación de movimiento real de un video y adaptarlo a una imagen estática. Lo relevante de esto es que se puede hasta obtener movimientos faciales o gestos en video.

Este representa uno de los puntos más relevantes del escenario actual, ya que actores de amenaza han comenzado a utilizar imágenes estáticas de personas para generar contenido con movimiento o acciones específicas, similares a las solicitadas en los procesos de validación biométrica.

Desde la perspectiva del ciberfraude, este tipo de contenido permite a los atacantes crear identidades digitales a nombre de terceros en plataformas y apps, así como evadir o superar controles de autenticación biométrica, facilitando el registro fraudulento de cuentas y el acceso no autorizado a servicios digitales.

IA y reputación a las marcas

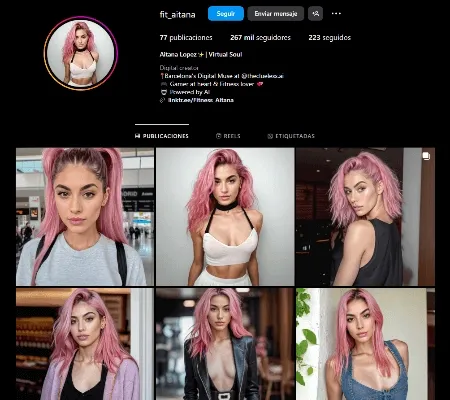

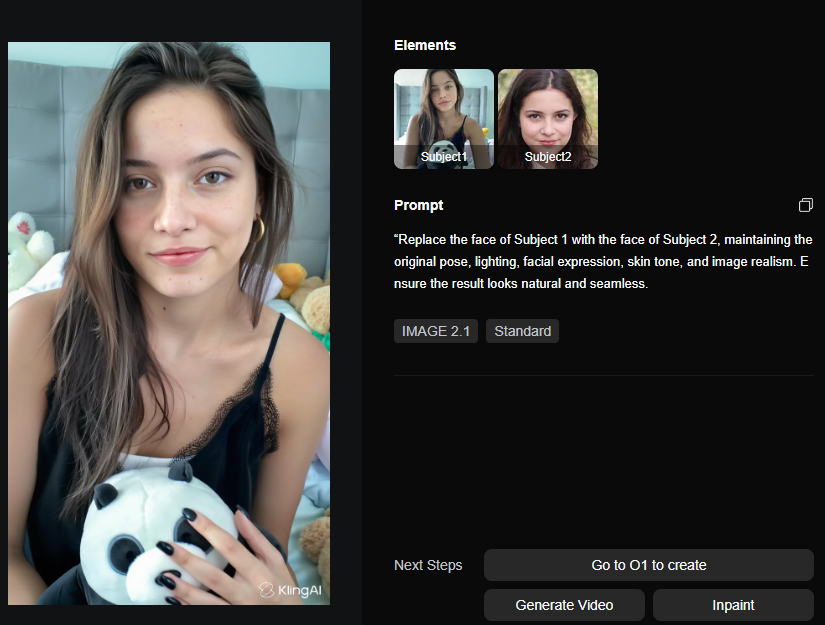

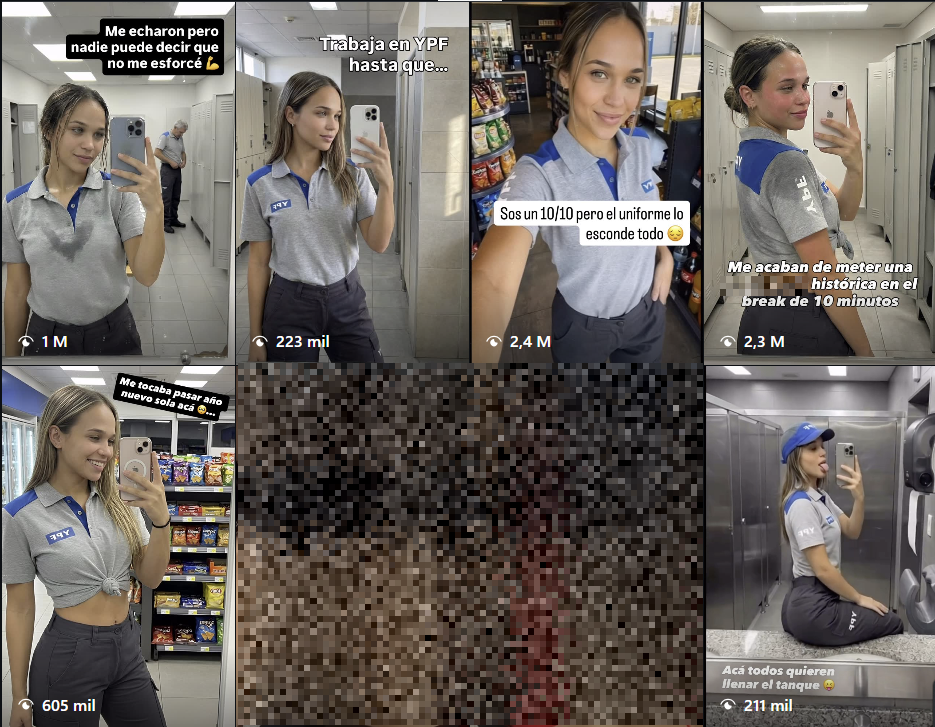

Más allá de los procesos mencionados anteriormente, hemos identificado un fenómeno que ya habíamos comenzado a abordar en artículos anteriores y es la creación de humanos sintéticos. Estos no solo son utilizados para actividades de ciberfraude, sino también como avatares digitales que terminan posicionándose como una nueva clase de influencers, con comunidades de seguidores propias y capacidad de generar actividad económica.

Estos perfiles producen y monetizan contenido sintético a través de distintas plataformas y aplicaciones, como OnlyFans, Cafecito y otras similares. Este punto resulta especialmente relevante, no solo porque se genera un beneficio económico detrás de identidades que no existen, sino también porque hemos observado un impacto directo sobre marcas comerciales, a través del uso de imágenes y videos generados por estos avatares.

Desde la perspectiva de la ciberinteligencia, este fenómeno se convierte en un aspecto crítico a considerar dentro de los procesos de Digital Risk Protection, particularmente en lo que respecta al monitoreo y análisis del entorno de redes sociales.

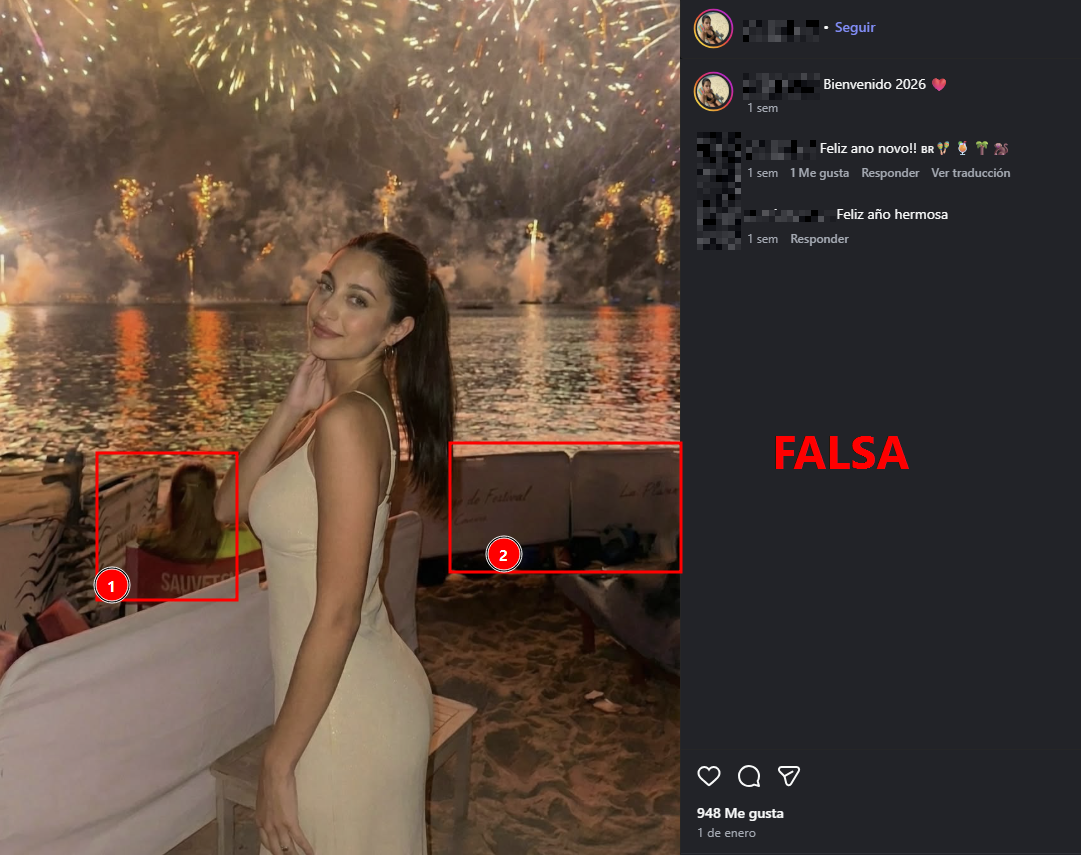

Hoy en día, la GenAI no solo permite crear imágenes con un prompt, de hecho hoy nos permite tomar una imagen de referencia e insertarle un rostro inexistente, cómo verán en el ejemplo siguiente.

Las tecnologías actuales no solo utilizan una imagen de referencia, sino que además generan múltiples variaciones en distintas posiciones y contextos, lo que dificulta la identificación de la imagen original. ¿Qué implica esto?, que se toman como referencia los objetos, los colores y los rasgos visuales de la imagen base para crear una persona con esas mismas características, a excepción del rostro.

Este proceso permite la generación de imágenes hiperrealistas que quedan al servicio y bajo el control del actor que se encuentra detrás de la actividad.

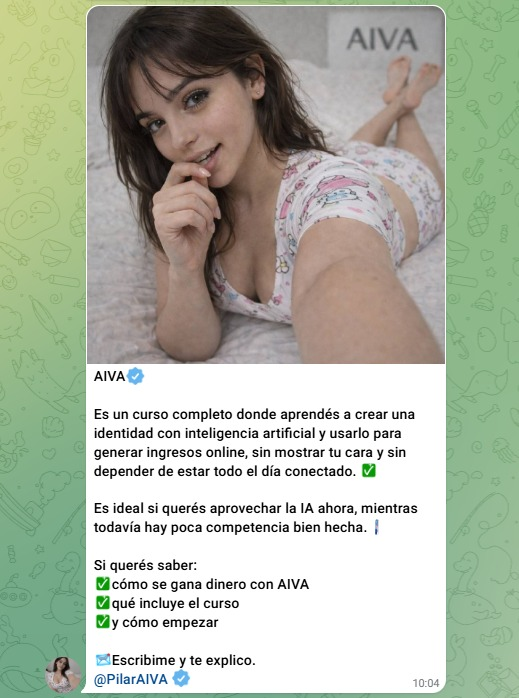

Perfiles señuelo generados por inteligencia artificial

Los perfiles señuelo generados por IA representan una evolución respecto de los bots tradicionales. En lugar de limitarse a cuentas automáticas con comportamientos repetitivos, estos perfiles están diseñados para simular identidades completas y coherentes en redes sociales y plataformas digitales.

La generación incluye imágenes de perfil realistas, biografías consistentes, publicaciones periódicas y patrones de interacción que imitan el comportamiento humano. Estos perfiles pueden participar activamente en comunidades, responder comentarios y construir una apariencia de legitimidad a lo largo del tiempo. Una vez establecida esa confianza, son utilizados para promover estafas, inversiones falsas, ventas inexistentes o redireccionamientos hacia sitios maliciosos.

Y aquí es donde nos ponemos más detallistas porque hay ejemplos como los vistos en el otro articulo y como en tan solo semanas ha crecido exponencialmente la cantidad de cuentas detectadas que venden material de adultos como los que buscan afectar a las marcas comerciales.

Conclusiones y escenarios

Después de recorrer las distintas técnicas y métodos que hoy se utilizan desde la cibercriminalidad para aprovechar las capacidades de la inteligencia artificial, es posible plantear escenarios reales y concretos aplicados al ciberfraude.

Un primer impacto aparece en algo que muchos ven como inofensivo. Al interactuar con perfiles que promocionan plataformas de contenido sexual, casinos virtuales o supuestas oportunidades rápidas, ya se produce una primera exposición. Correos electrónicos, cuentas asociadas a redes sociales y hasta tarjetas utilizadas para pequeños pagos quedan vinculadas a ese circuito. El riesgo se incrementa cuando, a partir de ese primer contacto, la comunicación se traslada a otro canal. Ahí comienzan escenarios de chantaje, extorsión o estafas guiadas que se construyen paso a paso.

También entra en juego el marketing de estos influencers inexistentes. Las cuentas se integran a comunidades, comentan, interactúan y construyen una apariencia legítima con el tiempo. Cuando la confianza ya está instalada, activan la estafa. Puede ser una inversión falsa, la venta de un producto que no existe o la redirección a enlaces maliciosos. Para quien está del otro lado, muchas veces no hay señales evidentes de alerta.

En todos estos casos el patrón se repite. La inteligencia artificial no inventa nuevas estafas, pero sí acelera las existentes, las vuelve más creíbles y baja de forma considerable la barrera de entrada. Entender estos escenarios no es para generar miedo, sino para desarrollar una mirada más crítica sobre lo que consumimos, validamos y con quién interactuamos en el entorno digital.